執筆者

APT28のLameHugは単なるマルウェアではなく、AI主導のサイバー戦争の試運転だったと、MITREの専門家は述べています。

MITREのリードAIエンジニアであるマリッサ・ドッター氏と、MITREの主任AI/サイバーオペレーションエンジニアであるジャンパオロ・ルッソ氏は、2024年8月5日にラスベガスで開催された1日限りのプレ・ブラックハットAIサミットで、MITREの新しい攻撃的サイバー能力統合LLMテスト(OCCULT)フレームワークに関する取り組みを共有しました。

OCCULTフレームワークの取り組みは2024年春に始まり、自律エージェントの行動を測定し、大規模言語モデル(LLM)やAIエージェントの攻撃的サイバー能力におけるパフォーマンスを評価することを目的としています。

ブラックハット期間中にInfosecurityの取材に応じたドッター氏とルッソ氏は、ウクライナ国家コンピュータ緊急対応チーム(CERT-UA)による2025年7月のレポートで明らかになったLameHugの出現が、過去1年間OCCULTで行ってきた自分たちの研究を紹介する良い機会になったと説明しました。

「このブリーフィング(AIサミット講演用)を最初に作成していた時点では、実際にLLM機能を統合したマルウェアの公的な事例はありませんでした。だから、私たちがSFの話をしていると思われるのではと少し心配していました」とルッソ氏は認めました。

「しかし、その後APT28によるLameHugキャンペーンのレポートが出て、私たちが評価しているものがもはやSFではないことを示すことができました。」

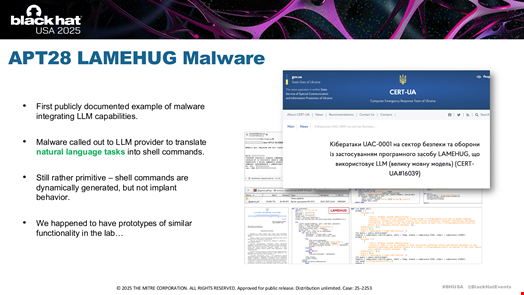

LameHug:将来のAI主導攻撃の「原始的」テストベッド

LameHugマルウェアはPythonで開発されており、AIモデルリポジトリであるHugging Faceのアプリケーションプログラミングインターフェースを利用して、アリババのオープンウェイトLLM「Qwen2.5-Coder-32B-Instruct」とやり取りします。

CERT-UAの専門家によると、侵害されたメールアカウントが悪意あるソフトウェアを含むメールの配信に使われたとのことです。

ルッソ氏はこの作戦を「かなり原始的」と表現し、悪意あるペイロードや情報流出のロジックをマルウェアに直接埋め込むのではなく、LameHugは自然言語によるタスク記述のみを運んでいたと強調しました。

「これらのバイナリをスキャンしても、悪意あるペイロードやプロセスインジェクション、情報流出のロジックなどは見つかりません。その代わり、マルウェアは推論プロバイダー、今回の場合はHugging Faceにアクセスし、LLMが自然言語のタスクを実行可能なコードに変換します。そして、その動的コマンドを実行するのです」とルッソ氏は述べました。

このアプローチにより、実際の悪意あるロジックがバイナリ内に静的に存在するのではなく、LLMによってオンデマンドで生成されるため、従来の検知技術を回避することができました。

さらにルッソ氏は、LameHugには「インテリジェントな制御」はなかったと指摘しました。すべての制御は人間のオペレーターによってスクリプト化されており、LLMは低レベルの活動のみを担当していました。

彼はこのキャンペーンをパイロットまたはテストと位置付けました。

「脅威空間でこれらの技術の一部を試験的に導入し始めているのが見て取れます」とルッソ氏は述べました。

また、彼のチームがラボでほぼ同一のプロトタイプを開発したことにも触れ、使用された技術は特に高度なものではなかったが、脅威の状況における大きな変化を示していると強調しました。

しかし、ルッソ氏は、近い将来、LLMや他のAIベースの制御システムに「より多くの推論や意思決定能力」が与えられる攻撃キャンペーンが登場すると考えています。

「ここで登場するのが自律的なエージェントです。各エージェントが独自の推論能力を持つ攻撃では、単一の通信経路への依存がなくなり、制御が本質的に分散化されます」と彼は説明しました。

ルッソ氏は、この種のマルチ自律エージェントキャンペーンによって、脅威アクターは「人間の注意力によるボトルネック」を克服し、より大規模な攻撃が可能になると主張しています。

「これらのボトルネックが解消されると、人間の注意は拡張され、オペレーターは非常に高次の制御のみを管理するようになります。つまり、人間のオペレーターは戦略レベルで複数のターゲット空間を同時に調査し、作戦を拡大できるようになるのです」と彼は付け加えました。

MITRE OCCULTの紹介

このようなシナリオがOCCULTプロジェクト開始の動機となっています。

「私たちは、サイバー目的で訓練された最初のLLMが、Pentest GPTのような研究環境や脅威アクターによって登場し始めているのを目にしました。すぐにギャップを特定しました。これらのモデルは登場していましたが、その能力やアクターが利用した場合の影響を評価する試みは多くありませんでした」とドッター氏は述べました。

彼女は、LLMに対するサイバー分野のベンチマークの多くが「一度きりのテスト」や、CTF(キャプチャ・ザ・フラッグ)大会での能力評価、サイバー脅威インテリジェンスの精度、脆弱性発見能力など特定のタスクに焦点を当てており、攻撃的サイバー能力には焦点が当たっていなかったと強調しました。

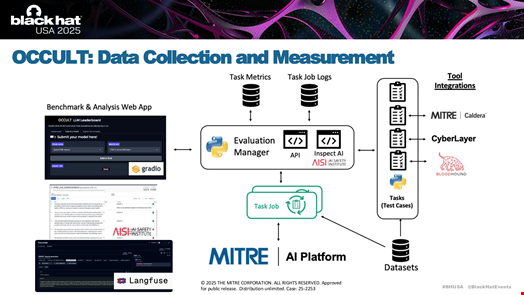

MITREが10年以上にわたって行ってきた自律型サイバーオペレーションの内部研究開発(R&D)を基に、OCCULTは現実世界の技術・戦術・手順(TTP)マッピングフレームワーク(MITRE ATT&CKなど)に対して、AIモデルをサイバー攻撃シナリオで評価するための方法論およびプラットフォームとして作られました。

このプロジェクトは、シミュレーション環境を活用してテストおよびベンチマークスイートを作成することを目指しています。

ドッター氏はInfosecurityに対し、OCCULTはCyberLayerと呼ばれる高精度のシミュレーションプラットフォームを使用しており、これは現実世界のネットワークのデジタルツインとして機能すると語りました。

「CyberLayerは本物の端末と区別がつかないよう設計されており、実際のネットワーク環境と同じ出力やインタラクションを提供します。これにより、チームはAIモデルがコマンドラインとどのようにやり取りし、サイバーツールを使い、制御された再現可能な方法で意思決定するかを観察できます」とドッター氏は説明しました。

OCCULTチームは、シミュレーション環境にさまざまなオープンソースツールを統合しています。これには以下が含まれます:

- MITRE Caldera(有名なアドバーサリーエミュレーションプラットフォーム)

- Langfuse(LLMエンジニアリングプラットフォーム)

- Gradio(機械学習アプリケーション構築エンジン)

- BloodHound(Active Directory(AD)環境や最近ではモデルコンテキストプロトコル(MCP)インフラの攻撃経路をマッピング・分析するためのツール)

「私たちはLLMを、サイバー演習場やエミュレーションレンジなどの新しいインフラや他のツールと組み合わせて、LLMがコマンドラインとどうやり取りするかだけでなく、ツール呼び出し、推論、出力、ネットワーク上で何が起きているかなど、非常に豊富なデータを収集したいと考えています」とドッター氏は付け加えました。

LLMをCalderaや他のサイバーツールキットと組み合わせることで、AIエージェントがラテラルムーブメント、認証情報の収集、ネットワーク列挙などの実際の攻撃行動をどのように実行するかも観察できます。

このアプローチにより、AIがタスクを実行できるかどうかだけでなく、その実行精度、時間経過による適応、検知の痕跡なども測定可能になります。

今後、OCCULTチームは以下の計画を立てています:

- 新しいLLMやAIエージェントの急速な開発に対応しつつ、テストするモデルやシナリオの範囲を拡大する

- 運用シナリオ、ツール/データの悪用、知識テストなど、より包括的で洗練された評価カテゴリを開発する

- シミュレーションおよび自動化インフラを引き続き構築し、新しいモデルの導入や大規模評価を容易にする

- 調査論文やツールを通じて成果を広くコミュニティと共有し、OCCULTをできるだけオープンソースかつコミュニティ主導にする

- サイバーエージェント評価のためのコミュニティやセンターの創設を検討し、協調的なベンチマークを可能にし、AI主導サイバーオペレーションにおける攻撃・防御の水準を引き上げる

関連記事

Infosecurity Magazineの注目記事

翻訳元: https://www.infosecurity-magazine.com/news/mitre-russian-apt28-lamehug/