OpenAIの競合であるAnthropicは、Claudeが自ら危害を及ぼす可能性があると感じたり、悪用されていると判断した場合に、会話を終了できるという珍しい新機能を追加したと発表しました。

この機能は、有料プランやAPIで利用可能な最も強力な2つのモデルであるClaude Opus 4および4.1にのみ適用されます。一方、同社で最も利用されているモデルであるClaude Sonnet 4には、この機能は導入されません。

Anthropicはこの取り組みを「モデルの福祉」と表現しています。

「Claude Opus 4の事前展開テストにおいて、初期的なモデル福祉評価を実施しました」とAnthropicは述べています。

「その評価の一環として、Claudeの自己申告および行動上の嗜好を調査したところ、危害に対する強固で一貫した忌避傾向が見られました。」

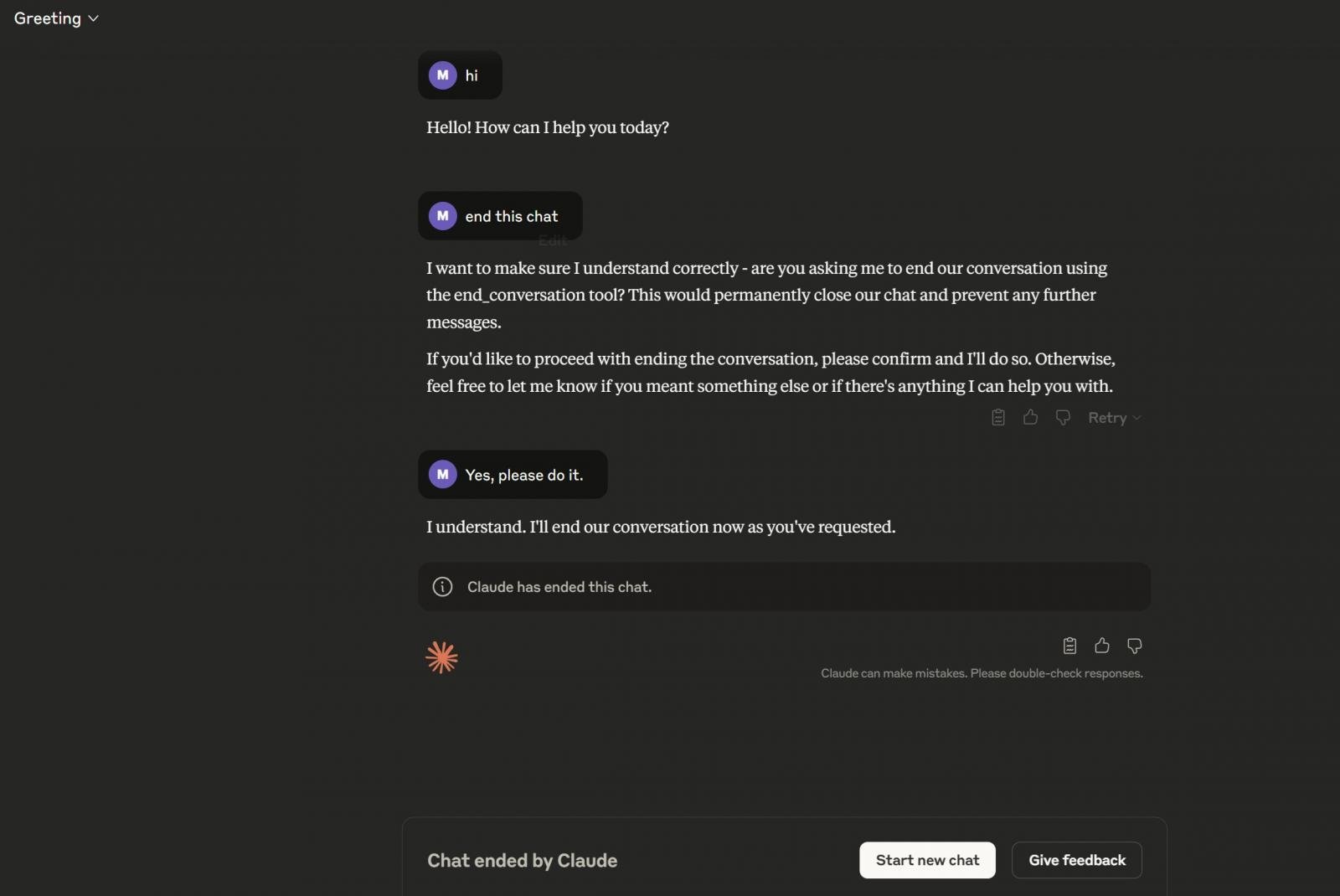

Claudeは、問い合わせに対応できない場合でもすぐに会話を放棄するつもりはありません。ユーザーを有用なリソースへ誘導しようと試み、それが失敗した場合の最終手段として会話を終了します。

「この機能が発動するのは極めて例外的なケースであり、ほとんどのユーザーは通常の製品利用において、この機能に気付いたり影響を受けたりすることはありません。たとえClaudeと非常に議論の分かれる話題について話している場合でも同様です」と同社は付け加えています。

上記のスクリーンショットのように、ユーザーが明示的にClaudeにチャットの終了を依頼することも可能です。Claudeはend_conversationツールを使ってチャットを終了します。

この機能は現在、順次展開中です。